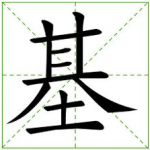

关于基

关于基

作者:@老师木

来源:www.guzili.com/?m=201308&paged=5

Basis是个挺值得琢磨的概念,基相当于坐标轴,任何一个物体可以向坐标轴投影,得到该坐标轴对应基的系数。这样给到基,任何物体都可由一组系数表示。线性空间正交基。傅立叶变换就是连续信号的正交基,信号之间内积变成积分的形式,不同频率的正(余)弦函数是正交的。

基决定了信号的表示形式。如时域表示和频域表示性质很不同,有时为处理方便更喜欢前者或后者。时域或频域都有自己的缺点,有个测不准定理。小波分析应运而生,gabor也属此类。能捕捉时域和频域的local性质。不同方法的区别就源于表达信号的基不同。

基有完备一说,即这些基无冗余。但compressive sensing反其道而行之,故意要over complete表示,正因over complete,表达每个信号非零系数的基个数相对于基的系数而言才是稀疏的。当然这里还有一个随机投影的问题,随机向量意味着和任何一个基的内积为零的概率很小。

无论是线性空间正交基,还是傅立叶变换的余弦函数,小波分析的wavelet的基都有特定函数形式,好比是通用配件分析上好操作。最理想的基是数据自适应的,即根据数据统计特性自己学习出一组基,相当于定制配件,当使用这个基表达这一类数据时自然比通用配件好。如何学数据自适应的基有很多门道。

有很多人从不同角度出发设计了很多机制去搞基,譬如数学的考虑,或仿生学人脑,最热闹的莫过于sparse coding了。因为有人莫名其妙设计了稀疏目标函数从自然图像patch上学到了一组基,从外观上看和人脑v1区简单细胞感受野类似,于是他们说这就是人脑的机制,而且大家都信,多扯淡啊,这篇文章发在nature上。

Deep learning啊,也基本是搞基的思路。只不过参照大脑不同层次用不同的基。搞基太难听了,有学者就起名feature learning或representation learning,其实feature就是基。@余凯_西二旗民工 有人跟帖说,基就是信号中蕴含的某种模式。没错,如果基捕捉了信号的统计规律,那是最好的。归根到底,这类方法还是受限假设空间去搜索、选择。

熵和基有很深的联系,以后再谈吧。

关于v1简单细胞神经元感受野为何类gabor,有比sparse coding更sound的理论,sparse coding就是歪门邪道,狗屎,正宗计算神经科学家人人得而鄙视之。

补充:和基非常相关的一个概念是滤波器,输入信号经过滤波器得到输出,滤波器从信号中提取出感兴趣或特定性质的东西。

来源:www.guzili.com/?m=201308&paged=5

留下你的评论