再谈深度学习文本的表示

作者:尹文鹏,德国慕尼黑大学博士研究生二年级,自然语言处理方向。先后在西北工业大学和北京大学获得本科,硕士学位。 小编:文本表示随着深度学习这把火也跟着旺了起来,各大会议上论文成出不穷,值得关注。

之前在百度开放研究社区写了篇``深度学习文本的表示'', 现在这篇姑且作为其升级篇吧。 因此本文再谈deep learning在文本表示学习方面的体会。

深度模型如何学习和表示词、短语、句子和篇章呢?

词: 以前表示词是所谓的distributional vector, 现在将词表示成embedding这种形式我觉得根本区别在于: 前者的每个维度有具体的含义, 而后者没有(虽然也有人称其为代表一个latent topic/semantic/element...)。 词的任何特性应该是由embedding vector中的所有维度共同决定的。 所以传统distributional vector里面我们可以删除一些维度或者增添一些新维度,但是embedding一旦训练好后是不可以这么做的。

目前为了得到更好的embedding的方法大致有: 1) 提出更强大的训练模型,从Bengio的到C&W的...再到近来有些将外在资源比如wordnet等融入word2vec训练的目标函数等等。 2)如果说方案1)是很理所当然的话,还有一种就是在得到训练好的embedding后再处理,比如NAACL'2015的一篇best paper ``Retrofitting Word Vectors to Semantic Lexicons''。 3) 第三种就是借助于更多元化的数据,这里典型的例子就是multilingual比如机器翻译方面的研究, 以及借助image, video, knowledge base数据来提升word embedding的。 4) 第四种路线包括各种”散打“模式,比如"WordRank : Learning Word Embeddings via Robust Ranking"

另外我还想讲讲embedding质量的评价问题。 大家最直接想到的应该是各种word similarity tasks。 我觉得还应该更强调以下几点: 1) 单纯用word similarity tasks是不能反映word embedding在真实NLP任务中的性能的,所以更应该使用真实的NLP task作为实验; 2) 应该覆盖semantic 和syntactic 两种基本指标; 3) 有些实验只关注于frequent words的表现,却忽视了怎么衡量rare words的质量。

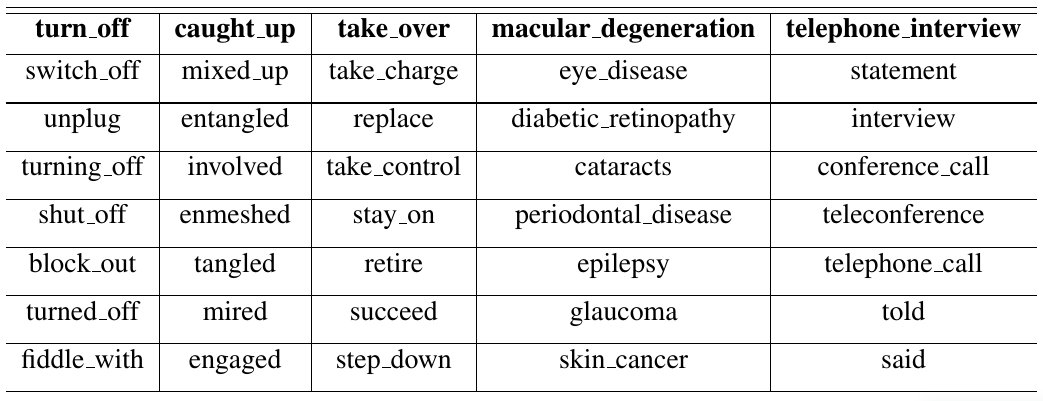

短语: ``phrase''这个词貌似在NLP文献里使用比较灵活。 我依然先介绍我们组在学习linguistic phrases方面的工作(如下表)。 在ACL'2014 SRW的工作中我们提出了简单有效的方法来解决如何学习不连续短语的表示问题,同时我们也发布了世界首份专门涵盖语言学短语(连续+不连续)表示的资源。

上述工作主要针对linguistic phrases,基本上就是指我们学英语过程中背诵的短语了。 另一个很有代表性的工作是随着word2vec工具一起发布的embedding set里面所含的phrase。 这是基于在大数据里面统计得到的phrase。 这两个工作都是将phrase处理后作为一个token再来训练的。 如果不考虑成一个token,就要研究compositionality了。研究组合性的工作在计算语言学界应该开始很早,在deep learning里有比如Socher的工作。 无论是当作一个token还是通过组合学习得到,都各有利弊: 作为一个token会造成phrase 作为rare token出现,难以保证得到高质量的embedding; 而通过compose来学习目前没得很robust的方案,尤其对于那些低组合度的短语。 这方面可以参看文献``A Word Embedding Approach to Predicting the Compositionality of Multiword Expressions''(这个工作好不好另说)。最近Yu et al., (TACL'2015) "Learning Composition Models for Phrase Embeddings"结合一些人工特征和word embedding的联合训练将组合型下phrase embedding学习在效率和效果上都有了较大提升。

还有一种工作是关于学习表示mutiword expression (MWE)的。方法上个人感觉没有什么特别的。 但总的来说,学习phrase/MWE层面上的表示一般会对很多任务有好处。比如(Duyu et al, ACL'2014)阐述了phrase的情感与其构成词的情感很可能不同。

短语的表示学习如上所述很难找到一个好的目标。 Hill et al., (arXiv 2015)提出了一种特殊情况下的phrase表示学习: 当phrase其实是对一个对象的定义或者说描述的时候。 文中考虑的phrase其实就是一个句子,而这个句子所描述的对象作为单个词出现。所以文中给这个phrase和word建立了一个match。 而这种match也只有在特殊的场景中才有用处。

句子: 句子的表示学习是NLP里面应用深度学习的一大热点。大体上可以分为有监督和无监督两种方案。 有监督主要面向各种分类任务,最典型的就是情感分析,各路论文大体上都是玩弄模型,尤其是CNN和RNN,但是模型仔细看起来也都差不多。发展到今天个人感觉已经麻木了。 无监督方案最典型的应该就是Mikolov的paragraph vector了,它学到的应该是一种unspecific的表示向量。我觉得它一个可能提高的方案应该结合上述的phrase embedding思路,将句子的表示在phrase层面上整合得到。现在的方案应该只是在单词上ensemble得到。

句子的建模当然也有一些有趣的新思路。 比如 Zhao et al, (IJCAI'2015)提出的同时考虑多种粒度:word--phrase--sentence的。这种想法也和我们在NAACL'2015 paraphrase任务上的结论是一致的。

篇章: 对篇章的表示目前有方案1) Oxford的Misha的工作喜欢先用CNN建立从word到sentence的模型,得到句子的表示后再用CNN建立sentence到doc的模型;2)其他的工作感觉模型上都差不多,都着重于对输入的理解上,比如(Xu et al., CIKM'2012, Johnson et al., NAACL'2015, Zhang et al., arXiv 2015)

几大前景方向:

个人觉得深度学习在自然语言处理领域有如下几个很有前途的应用领域:

- 多媒体结合: 现在很多深度学习的研究都是跨媒体的,常见的有给图片产生描述,给视频产生描述之类的。也有通过图片或视频或音频来辅助训练文字的表示。归根结底,这是与人类学习过程向拟合的,必然是深度学习发展的趋势。

- 问答系统: 我相信智能问答系统的研究还相当初级,目前能大致应付的也仅仅是简单预先设置的问题类型。要建立更智能的问答系统,需要建立大型的,实时的知识库,以及推理算法。深度学习貌似在知识的表示,知识库的完善上有所帮助。但其能否在QA任务上有更深的介入,让我们拭目以待。 目前主流互联网公司都好像在涉足QA系统。

- 翻译系统: 机器翻译论文貌似是各大会议的重头,有时候感觉有点``小滥'',但机器翻译也是最直接让用户受益的技术之一。目前英语对德语,法语等翻译效果感觉还挺不错。但是中文等不同语系的还有很长的路要走。深度学习跨语言训练的效果最近使得机器翻译领域进步不少。

- 信息抽取与知识库建立:这个感觉是最终实现人工智能必须要进行的艰苦卓绝而又漫长的基础工程。目前很多任务都是在极为有限的数据上跑,无论多么先进的算法都会遇到瓶颈(就像给一个data让你训练word embedding的时候,到word2vec后我想已经很难再提高了,除非各种加外在的数据)。而单纯的big data还不够,只有抽取出知识并建立知识库才能体现其效力。

- 自动文本生成:让计算机通过学习然后自动生成语法正确,语义明确,又有层次的文本,这应该是NLP终极梦想之一。无论是上面说的问答系统,文摘系统,都会建立在计算机的这种文本输出能力。 这方面有篇很有趣的文章"A Hierarchical Neural Autoencoder for Paragraphs and Documents"

眼界所限,随便漫谈,欢迎讨论。

留下你的评论